近日,实验室王平教授团队与上海交通大学合作撰写的论文“Multi-modal Auto-regressive Modeling via Visual Tokens”被ACM Multimedia 2024(第32届国际多媒体大会)录用为海报展示(Poster)。会议将于2024年10月28日至11月1日在澳大利亚墨尔本召开。ACM Multimedia是中国计算机学会CCF推荐的A类学术会议,今年共有4385 篇提交进入了评审阶段,其中1149篇被录用,录用率为26.20%。

大型语言模型(LLMs)通过在大规模未标记文本上进行自回归建模,能够从自然语言语料库中学习通用语义信息和强大的推理能力。然而,将这种方法扩展到多模态场景时面临挑战:图像信息在LMM中被处理为连续的视觉嵌入,无法获得离散的分类损失监督标签。

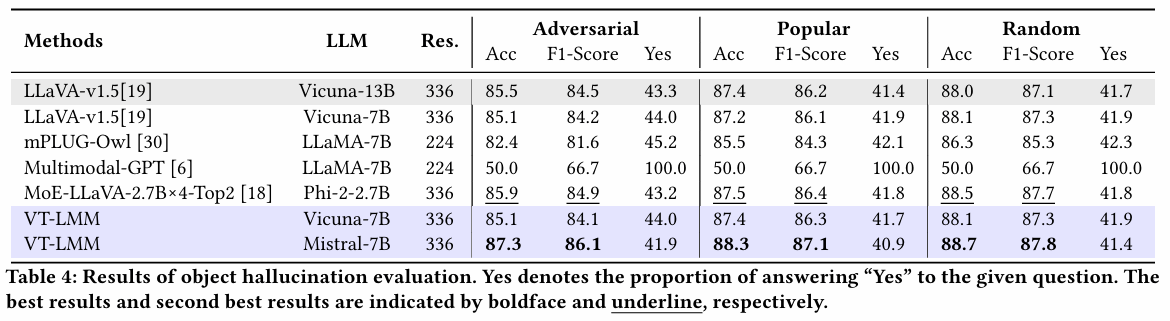

本文首次实现了统一目标的多模态自回归建模,并探讨了LLMs内部语义空间中视觉特征的分布,以及用文本信息表示不同模态的可能性。为解决这一问题,研究者提出了VT-LMM(Visual Token guided Large Multi-Modal Model),引入视觉令牌(visual tokens)的概念,构建视觉特征在LMM语义空间中的分布,提供用于视觉建模的监督信息。

对于图像中的每个图块,研究者选择其对应视觉令牌中概率最高的标记在图中进行展示。结果表明,视觉令牌成功地实现了视觉特征向文本语义空间的转换。

本研究首次实现了具有同一目标的多模态自回归建模,通过视觉令牌构造不同模态的信息在共享语义空间中的存在形式,从而为视觉建模和语言建模提供监督标签,显式补充了模型对视觉内容分布的学习过程。进一步,研究者探究了不同模态信息在大模型内部语义空间的一致存在形式以及使用语言信息表示不同模态特征的可行性。